「AIによる業務効率化」がブームだ。といってもAIが仕事に使える、使わなければという機運が高まったのもこの1年足らずのことだし、技術動向が目まぐるしく変わっていることもあって、いまだ「定番」と呼べるスキルは生まれていない。プロンプトエンジニアリングが大事になるぞとか言われていたかと思えば、データ分析、画像生成、直近では動画の生成などが話題になり、「何に使える技術なのか」というイメージすら明確ではないのが現状だ。

こういうときに、新しもの好きというか、アーリーアダプター層とマジョリティの間の「キャズム」はずいぶん大きなものになると思われる。マジョリティ層が「使い方や規制の動向がはっきりするまで待っておこう」と考えるのに対し、アーリーアダプター層は次々と新しいものを試し、それによってAI活用の「コツ」のようなものを掴んでいく。おそらくそれはかつての「検索エンジンの使い方」と一緒で、言語化しづらい暗黙知でありながら、できる人はなぜかできるし、できない人は何ができないのか分からないようなものになるのだろう。

僕自身は上の区分で言えばアーリーアダプター層であり、現在も多くのAI関連サービスに課金して技術的な可能性を探っている。さらに言えば、研究・教育に従事する立場としては、かねてから様々な技術を取り入れてきた(院生の頃には研究室向けに、簡易SNSのようなものを開発したことすらある)。大学という巨大組織では、学生全員に新しい技術を使ってもらうのは困難だけど、自分のできる範囲で活用していることは色々あるので、この際にいくつか紹介してみようと思う。

ルーティンの情報整理

研究活動の基本となるのは、情報収集であり、収集した情報の整理だ。特に自分のような実際の社会の動きと研究テーマが重なるような分野では、ジャーナル論文だけを読んでいてもだめで、新聞、ネットニュースから動画コンテンツ、文芸まで幅広いトピックが情報収集の範囲になる。

こうした雑多な情報を収集する際には、シンプルな原理に則った日常のルーティンが大事になる。僕の場合は

- 気になった情報は精査・精読せずに、とにかくひとつのデータベースにすべてをクリップする

- 定期的に情報整理の時間を作って、要約やタグなどの情報を付加しておく

- アウトプットのために必要になったタイミングでデータベースから情報を検索して精査する

という流れになっている。いわば「自分用の情報ソース」を構築しておくのだが、ここで大事になるのが2の情報の整理作業だ。ここで検索性の高い情報を付加しておくことと、そして、その作業を通じてざっくりとでも内容を把握しておくことが、後で情報を活用する際に効いてくる。

AIによる効率化は、主にこの整理作業の段階で導入されている。データベース(現在はNotionを利用している)に全文保存しておいた記事をNotion AIの要約機能を用いてサマライズし、ざっくりと内容を把握した上でタグを付ける。タグ付けは、たとえば講義の準備の際に「個人情報保護法の改正がどのような流れで行われてきたか」といったピンポイントなトピックを検索する際に用いる。大学で提供されている新聞記事検索ではどうしても不要な情報が多くなるので検索に時間がかかるから、あらかじめ自分の基準でピックアップした記事だけを集めておく方が効率的なのだ。

効率的と行っても、そもそも記事を保存したりサマライズしたりする作業は手作業だし、僕の判断も必要になっている。本来であればこの種の作業をすべて自動化することも可能なのだが、情報収集の目的は「確かこんな話があった」ということをぼんやりと把握しておいて、あとから検索できるようにすることなので、そこを省力化することに意味はない。どちらかというと「手動作業の効率化」に特化した上で、記事の要約をざっくり確認したり、簡単なコメントを入れたりすることで記憶を刺激しておくようにしている。

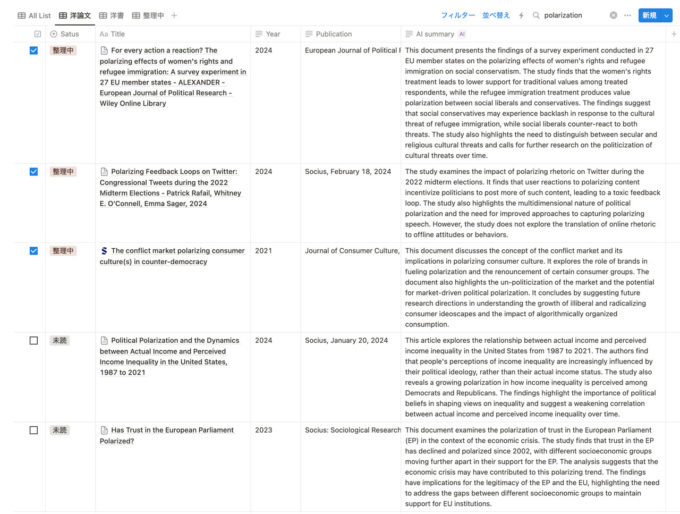

同じような作業は学術論文でも行っている。社会学、政治学などの英語ジャーナルはRSSを配信しているものも多いので、ニュースチェックの際に一緒に気になる論文をピックアップして、ニュースとは別のDBに保存している。また日本語の論文の多くはPDFしかないので、ChatGPTにサマリを出力させている。こちらのDBにもAIによるサマライズのプロパティがあるのだが、そもそも論文にはアブストラクトもあるので、DeepLで翻訳した日本語のアブストラクトもDB内に保存しておく。こうすることでNotionを検索する際に、日本語キーワードでニュースも論文も引っかかるようにしておくわけだ。

Notion AIとChatGPTの使い分けだが、これは単純にインプットできる情報のサイズによる。テキスト化されたデータの場合、ChatGPTに全文を一気に入力することはできないが、Notionであれば(限界はあるものの)ページのデータを全部読み込んだうえでサマライズしてくれる。逆にPDFのデータはNotionでは読めないので、ChatGPTに読み込ませている。

なお、ここで紹介した流れで作成したまとめ音声は、noteの方で週1回配信している。発音が不正確だったりするのだが、ニュース記事のDBさえ用意しておけばほぼ全自動で記事が作成されるので、備忘録としてポストしているものだ(無料記事だが、Open AI APIの課金の足しにはなるのでサポートも大歓迎)。

「自前でやってみたかったあれ」の手伝い

さて、この記事の本題はここからだ。上のような「自分の手でやらないといけない作業を可能な限り効率化する」というのは、いわば「手間や負荷になっている部分を減らす」という減算的な活用法だ。それに対して「自分でやらなくてもいいかもしれないが、できたら自前でやってみたいことをAIの力を借りて実現する」という加算的な活用法もある。進化の早い生成AIの活用の可能性を広げるとすれば、むしろこの部分だと僕は思っている。

たとえば、上で挙げたnoteの記事のサムネイル画像はBing Image Creatorで生成したものだ。これまでであれば自分でロゴや画像を作成したり、フリーの画像の中から最適なものを探したりしていた手間がほぼなくなり、「こういうサムネイルで」とオーダーするだけになっている。

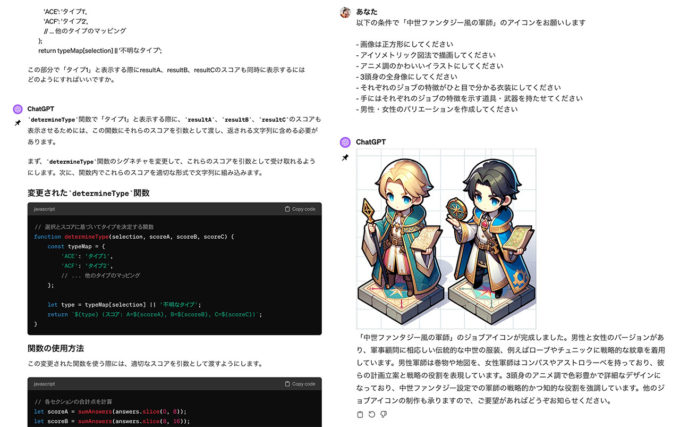

画像を生成するだけではもったいない。最近、学生向けに「自分のチーム内での振る舞い方を診断するウェブページ」を作成する機会があったのだけれど、そのページのコードや診断結果に表示される画像(この場合は、「あなたをRPGのジョブで例えると」という設定にした)も、すべてChatGPTにお願いして出力してもらったものだ。

ここでポイントになるのは、コードも画像も「自分で作成しようと思えばできないことはないが、膨大な時間がかかるし、納得のいくクオリティにならない可能性が高い」ということだ。それならば「こういうことを、こういう挙動で実現したいのだけど、どうすればいいか」と聞いてしまった方が早い。出力されたものが意に沿わないものであれば、ここをもっとこうしてくれと再度頼めばいいし、仕様が変更されたらそれを伝えればいい。「やっぱりこう変えたいんだけどお願いできる?」と人間に頼むと嫌な顔をされたり追加料金を請求されたりするが、そういう心配もない。

要するにAIは「自分ではやりたくない面倒なことをお願いする」だけでなく、「自分なりに実現したい形があって、でも自分ひとりではできないことをお願いする」ときに力を発揮するのだ。最近のケースで言うと、アンケート調査の調査票を設計する際に、あらかじめ分析仮説と用いる変数のイメージを伝えて、それを具体的な質問項目にする際にChatGPTを利用した。分析に必要な変数が連続量なのかカテゴリカル変数なのかといったことについて説明されれば僕でも理解できるし、それに見合った質問文はどのようなものになるかも相談できる(もちろん最終的には専門的なテキストを読んでウラを取るのだけど)。

また、こだわりという点では音楽活動にもAIは活かされていて、1月に配信したアルバムのジャケット写真はChatGPTに何度もオーダーして作ったものだ。最終的にはPhotoshopなどで修正は入れているものの、「アルバムのイメージがこうなので、こういうモチーフで、こういう図案で、こういう要素を入れてほしい」といった「作者なりのこだわり」を伝えて具体化する作業を行った。考えたらこういうことはこれまで本を出版する際も人間相手にやってきたわけだけれど、「仕上がりへのこだわりがある人が80点くらいのものを生成してもらって最終的に自分で完成形にもっていく」ことができるようになったと実感している。

誰にとっての福音なのか

僕の使い方は、昨今あちこちで見かける「AIってこんなことにも使えますよ」という本や記事と比較しても特殊だし、ノウハウとしてそのまま役に立つというものではないかもしれない。ただ、こうした活用を通じて見えてくるのは、AIとその関連技術が、誰にとっての福音になるのかということだ。

新しい技術が雇用を奪うというとき、これまで技術的失業の対象とされてきたのはルーティンワーク従事者だった。それに対して生成AIの登場に端を発する最近のブームには、知的業務の中でも付加価値の低いルーティン作業が代替されるという議論と、人間に頼らざるを得なかった専門的な仕事が代替されるようになるという議論の両方が存在している。そもそも失業者は技術のインパクトのみで増えたり減ったりはしないので「仕事がなくなる」という言い方は単純すぎるけれど、より影響がありそうなのは後者の専門職の方かもしれない。

そう考えられる主な理由は2つある。1つは、生成AIの出力が十分に役立つものになっているからだ。既に挙げた通り「ある程度」のクオリティでいいのであれば生成AIが出力する結果は「すぐ使える」レベルに達している。とりわけ、「ある程度」の要求水準が標準的なものであり、その水準について伝達できるだけのこだわりをもっている人にとっては、「ある程度」でいいからスピードやコミュニケーションの簡略化というメリットをとってAIに任せることが選択肢になり得る。

もう1つの理由は、逆に、自分がすでに精通している分野においては、生成AIはちっとも「役に立たない」ということだ。巷で言われる「AIが役立たない」という議論の根拠の多くは、「自分がよく知っていることについてデタラメな回答が出力された」ことを根拠にしている。言い換えると、AIは既に賢くなった人間の賢さを高めることはできず、そうした賢さを「ある程度」の水準で、他の賢くない人に民主的にアクセスできるようにする技術なのである。

昨今、イラストレーターや脚本家など、創造的な分野のクリエイターから生成AIに対する懸念や批判の声が上がっているのも、こうしたことと無関係ではない。だがより影響が大きいのは、プログラミングであるとか会計処理といった、「(効率や正確性を目標とする)正解」が存在し、その正解を導くのに専門性が必要とされていた分野の仕事だろう。こうした分野の仕事はもしかすると、実作業の部分をAIが担い、人間は最終チェックと責任を持つことだけを求められるものになるかもしれない(この点では、製造業が職人から生産管理へと移ってきた歴史の焼き直しにも見える)。

とはいえ、こうした見通しは極端なものでしかない。福音といっても、そもそもプロ並みのこだわりでAIに指示を出すことのできる人は多くないし、大半の人は「自分で指示を出すために頭を使うくらいなら、すべてを自動処理してくれるなにか」に自分のタスクを委ねたいと思っている。その「なにか」の中身がAIであるか人間であるかは、さしあたって問題ではないのだ。

さらに言うなら、そもそも現在の生成AI技術は情報の出力に特化しており、どこまで自動化しても物理空間に干渉する直接的な力をもたない。そもそも、情報が物理空間を動かすといっても、たとえば室内の気温をセンサーで読み取ってエアコンが自動調整するくらいのことならAIでなくてもできる。こうしたことを考えるなら、生成AIがもたらすのは「やろうと思えばものすごいことができるはずなのに、使いこなせる人がいないので社会的なインパクトも限定的になる」という未来かもしれない。

いまはまだ「あれもできる、これもできる」とキャズムの手前で盛り上がっている段階の生成AI技術だけれど、もしそのキャズムの向こう側があるとしたらそれは、「AIでないとできないものすごいこと」を、誰もがそうと意識せずに利用するようになった社会なのだと思う。